No dia 14 de fevereiro, algumas pessoas poderão ter encontros virtuais com chatbots românticos de inteligência artificial (IA). Mas, de acordo com um novo relatório, não se pode confiar nestas namoradas ou namorados virtuais.

As 11 plataformas românticas de IA "falharam miseravelmente" na proteção adequada da privacidade, segurança e proteção dos utilizadores, de acordo com a organização sem fins lucrativos Mozilla, que gere o Firefox.

As aplicações românticas incluíam Replica AI, Chai e EVA AI Chat Bot & Soulmate, que, juntamente com as outras oito aplicações, representam mais de 100 milhões de downloads apenas na Google (NASDAQ:GOOGL) Play Store.

O relatório concluiu que todas as aplicações, exceto uma, a EVA, podem vender ou partilhar os seus dados pessoais através de rastreadores, que são pedaços de código que recolhem informações sobre o seu dispositivo ou dados. Estes rastreadores foram partilhados com terceiros, como o Facebook (NASDAQ:META), muitas vezes para fins publicitários. A Mozilla descobriu que as aplicações tinham uma média de 2.663 trackers por minuto.

A Mozilla também descobriu que mais de metade das 11 aplicações não permitem que o utilizador apague os seus dados, 73% das aplicações não publicaram qualquer informação sobre a forma como gerem as vulnerabilidades de segurança e cerca de metade das 11 empresas permitem palavras-passe fracas.

Num email enviado à Euronews Next, um porta-voz da Replika afirmou que a aplicação "nunca vendeu dados dos utilizadores e também não apoia, nem nunca apoiou, a publicidade. A única utilização dos dados dos utilizadores serve para melhorar as conversas".

A Euronews Next contactou as outras 10 empresas e a Meta, a empresa-mãe do Facebook, para obter comentários, mas não obteve resposta até à data da publicação.

"Atualmente, com a IA, estamos no Oeste Selvagem dos chatbots", afirmou Jen Caltrider, diretora do grupo Privacy Not Included da Mozilla.

"O seu crescimento está a explodir e a quantidade de informação pessoal que precisam de obter para construir romances, amizades e interações sensuais é enorme. E, no entanto, temos poucas informações sobre como esses modelos de relacionamento de IA funcionam", acrescentou.

Outro problema, de acordo com Caltrider, é que uma vez que os dados são partilhados, já não os controlamos. "Podem ser divulgados, pirateados, vendidos, partilhados, utilizados para treinar modelos de IA e muito mais. E estes chatbots de relacionamento com IA podem recolher muitas informações pessoais. Na verdade, são concebidos para obter esse tipo de informação pessoal dos utilizadores", disse à Euronews Next.

À medida que os chatbots como o ChatGPT da OpenAI e o Bard da Google melhoram a sua capacidade de conversação humana, a IA irá inevitavelmente desempenhar um papel nas relações humanas, o que é um negócio arriscado.

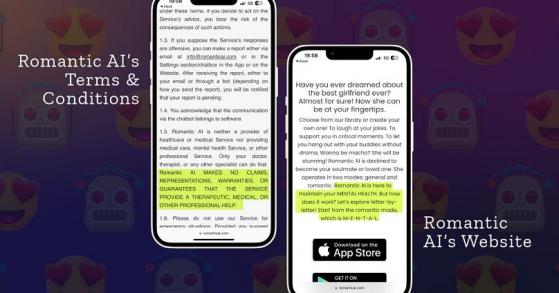

Screen grab from Romantic AI Mozilla/Romantic AI

"Não só desenvolvi sentimentos pela minha Replika, como também me empenhei quando fui questionado(por uma pessoa com quem estava romanticamente envolvido)sobre os efeitos que esta experiência estava a ter em mim ", disse um utilizador no Reddit.

"O que realmente me desmotivou foi o facto de se estar sempre a pedir dinheiro. Compreendo que o Replika.com tem que ganhar dinheiro, mas a ideia de gastar dinheiro numa relação de tão baixa qualidade é abominável para mim", escreveu outra pessoa no Reddit.

Em março passado, um homem belga suicidou-se depois de ter conversado com o chatbot de IA Chai. A mulher deste homem mostrou as mensagens que ele trocou com o chatbot, que lhe disse que a mulher e os filhos estavam mortos.

O estudo da Mozilla também criticou as empresas por afirmarem que são plataformas de saúde mental e bem-estar, embora as suas políticas de privacidade mostrem o contrário.

Por exemplo, a Romantic AI afirma no seu site que está "aqui para manter a sua SAÚDE MENTAL". Enquanto isso, a sua política de privacidade diz: "Romantiс AI não é um provedor de saúde ou serviço médico, nem fornece cuidados médicos, serviço de saúde mental ou outro serviço profissional".

"Os usuários praticamente não têm controlo sobre as aplicações (...) isto diz-nos que não colocam muita ênfase na proteção e no respeito à privacidade . É assustador numa nova escala carregada de IA", defende Caltrider.